Mit Hochdruck wurde seit der Einigung im Trilog Anfang Dezember am AI Act gefeilt. Diese Woche hat Euractiv den vorläufig finalen Text geleaked. Das knapp 900-seitige Markup enthält die Positionen der EU-Kommission, des Parlaments, des Rats und der (vorläufigen) finalen Einigung. Wir haben uns einen Überblick verschafft und fassen die wichtigsten Eckpunkte, Änderungen sowie den Handlungsbedarf zusammen:

Welche KI-Systeme werden reguliert?

Über die Abgrenzung zwischen künstlicher Intelligenz und klassischer Software herrschte lange Zeit Uneinigkeit. Die aktuelle Definition erfasst nunmehr maschinengestützte Systeme, die mit einem unterschiedlichen Grad an Autonomie operieren können und das gegebenenfalls nach der Implementierung lernfähig ist, wodurch Schlüsse gezogen werden, die die Umgebung beeinflussen können. Das können beispielsweise generierte Inhalte, Vorhersagen, Empfehlungen oder Entscheidungen sein. Diese KI-Systeme fallen unter den AI Act, sofern keine Ausnahmebestimmung greift, wie zB:

- Modelle, die ausschließlich für wissenschaftliche Forschungszwecke entwickelt und in Betrieb genommen werden;

- Open Source AI, wenn es sich um keine verbotenen oder hochriskante KI-Systeme handelt;

- Forschungs-, Test- und Entwicklungstätigkeiten vor der Markteinführung bzw Inbetriebnahme, sofern diese nicht unter realen Bedingungen erfolgt;

- Einsatz von KI durch natürliche Personen für private Zwecke (Haushaltsausnahme).

Diese Abgrenzungsfragen sind der Startpunkt jeder Bestandsanalyse und Evaluierung neuer Umsetzungsprojekte im Unternehmen.

Welche Pflichten sind einzuhalten?

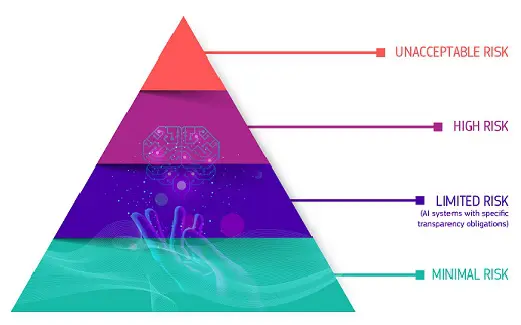

Die Pflichten richten sich nach der Risikoklassifizierung von KI:

In der Praxis ist insbesondere die Frage, ob ein Hochrisiko-System vorliegt, essenziell. Schließlich knüpfen die meisten Pflichten des AI Act an diese Einordnung. Die Abgrenzung wird sowohl positiv als auch negativ getroffen, wobei stets Risiko einer Schädigung der Gesundheit, Sicherheit oder Grundrechte natürlicher Personen im Vordergrund ausschlaggebend und daher ein Human Rights Impact Assessment notwendig ist:

Zu den Hochrisiko-Anwendungen zählen Systeme, die selbst Produkte oder Sicherheitskomponenten von Produkten sind, die im Anhang II der Harmonisierungsrechtsvorschriften der EU fallen und die einer Konformitätsprüfung unterzogen werden müssen. Betroffen sind davon etwa Flugzeuge, Autos aber auch medizinische Geräte.

Daneben werden auch solche KI-Lösungen als Hochrisiko-Systeme vermutet, die in einem der Bereiche des Anhang III des AI Act fallen. Das schließt insbesondere Anwendungen zur biometrischen Identifizierung, Bewerberauswahl, Strafverfolgung oder Implementierung in kritischen Infrastrukturen ein. Ausgenommen davon sind Anwendungen, die kein signifikantes Risiko einer Schädigung der Gesundheit, Sicherheit oder Grundrechte natürlicher Personen haben. Dies ist der Fall der Fall, wenn eines oder mehrere der folgenden Kriterien erfüllt sind:

- Das KI-System ist dazu bestimmt, eine eng begrenzte Verfahrensaufgabe auszuführen;

- das Ergebnis einer zuvor ausgeführten menschlichen Tätigkeit zu verbessern;

- Entscheidungsmuster oder Abweichungen von historischen Entscheidungsmustern zu erkennen, und soll die zuvor durchgeführte menschliche Bewertung nicht ersetzen oder beeinflussen, ohne dass eine ordnungsgemäße menschliche Überprüfung stattfindet; oder

- das KI-System soll eine vorbereitende Aufgabe für eine Bewertung übernehmen, die für den Zweck der in Anhang III aufgeführten Anwendungsfälle relevant ist.

Profiling birgt unabhängig davon jedenfalls ein hohes Risiko in sich.

Anwender von Hochrisiko-KI müssen ein Risikomanagement einrichten sowie hohe Anforderungen an Datenqualität, Dokumentation, Transparenz und technischer Robustheit beachten. Weiters sind Human Rights Impact Assessments zwingend durchzuführen. Werden KI-Systeme von Dritten zugekauft, so sind darüberhinaus auch entsprechende Vereinbarungen notwendig.

General Purpose AI

Ein besonderer Abschnitt ist seit dem ChatGPT-Hype auch „General Purpose AI Models“ („GPAI-Modelle“) gewidmet. Nutzer derartiger Systeme müssen zusätzlich besondere Pflichten erfüllen. Auch hier folgt der EU-Gesetzgeber wieder einem risikobasierten Ansatz und unterscheidet zwischen (i) einfachen GAPI Modellen und (ii) GPAI Modellen mit systemischem Risiko (also einer Rechenleistung für das KI-Training mit mehr als 10^25 FLOPS).

Im ersten Fall müssen das technische Modell, insbesondere Training, Testing und der Evaluierungsprozess dokumentiert, Informationspflichten erfüllt, Urheberrechte gewahrt und eine Zusammenfassung der Traininginhalte veröffentlicht werden. Ausnahmen gelten zum Teil für Open Source GPAI.

GPAI Modellen mit systemischem Risiko müssen zusätzlich die potenziellen Risiken bewerten und verringern, besondere Vorfälle melden und ein ausreichendes Niveau an Cyber-Sicherheit gewährleisten.

Umsetzungsfrist und Strafen

Sobald der AI Act offiziell verabschiedet wurde, gilt folgende abgestufte Anwendbarkeit:

- Der Verbotskatalog gilt nach 6 Monaten;

- Die Verpflichtungen für Foundation Models gelten nach 12 Monaten;

- Die Hochrisiko-Anwendungen nach Annex III gelten nach 24 Monaten;

- Die Hochrisiko-Anwendungen nach Annex II gelten nach 36 Monaten.

Ein Verstoß gegen die Auflagen für verbotene KI-Systeme wird mit Geldbußen von bis zu EUR 35 Mio oder von bis zu 7 % des gesamten weltweiten Jahresumsatzes geahndet. Damit wird der empfindliche Strafrahmen der DSGVO gesprengt. Werden Anforderungen an Hochrisikosysteme missachtet, drohen Strafen von bis zu EUR 15 Mio oder von bis zu 3 % des gesamten weltweiten Jahresumsatzes. Unrichtige, unvollständige oder irreführende Auskünfte an zuständige nationale Behörden können im Zusammenhang mit dem AI-Act zu Strafzahlungen von bis zu EUR 7.5 Mio oder bis zu 1 % des gesamten weltweiten Jahresumsatzes führen.

Handlungsbedarf

Der Weg zu AI Act-Compliance – Da die Pflichten nach dem AI Act technisch, organisatorisch und rechtlich herausfordernd sind, sollten Unternehmen mit einen strukturierten Fahrplan arbeiten, der jedenfalls folgende Milestones enthält:

- Festlegung einer KI-Strategie

- Definition einer KI-Governance

- Durchführung einer Bestandsanalyse und Evaluierung von KI-Systemen iSd AI Act

- Prüfung allfälliger Ausnahmen vom Anwendungsbereich

- Risikoklassifizierung der einzelnen KI-Systeme und Umsetzung der entsprechenden Pflichten

- Dokumentation

- Laufendes Monitoring

Die Umsetzungsfrist ist insbesondere für die Identifikation und Einstellung von verbotenen KI-Systemen bzw für Foundation Models äußerst knapp. Daher ist es notwendig, sich schon im heurigen Geschäftsjahr damit zu beschäftigen und das KI-Compliance-Projekt in die Wege zu leiten.